Hoy te quiero traer algunas herramientas útiles de IA para Linux, fáciles de usar y en LOCAL, sin código ni programación de ningún tipo.

Aclaraciones:

- Esto NO es un TOP, por tanto no tienen ningún orden en especial.

- Aunque estas herramientas son fáciles de utilizar, algunas tienen opción de ajustar manualmente algunas cosas, no es necesario que las toques pero si que es muy útil saber para que sirven, puedes optimizar mucho más las cosas.

- Estas herramientas son totalmente Offline, solo requiere descargar el modelo que vas a utilizar, todo pasa en tu equipo, no dependes de ningún servicio de terceros.

- Los modelos que descargues requerirán de memoria GPU (VRAM) para funcionar rápidamente, también existe la opción de utilizar solo CPU aunque será todo bastante más lento, usando CPU utilizaras RAM en vez de VRAM.

Dificultad de instalación 1 - 4

1 = A golpe de click

2 = Requiere de terminal

3 = Terminal + Configuraciones

4 = ![]() (ojalá no deba poner ninguna aquí)

(ojalá no deba poner ninguna aquí)

Lista:

- Jan (1)

- LM Studio (1)

- GPT4all (1)

- Stable Diffusion WebUI (AUTOMATIC1111) (2)

- Invoke-ai (2)

- Ollama + Open-WebUI (3)

- F5-TTS (Clonación de voz en español) (HuggingFace | GitHub) (1 en HuggingFace)

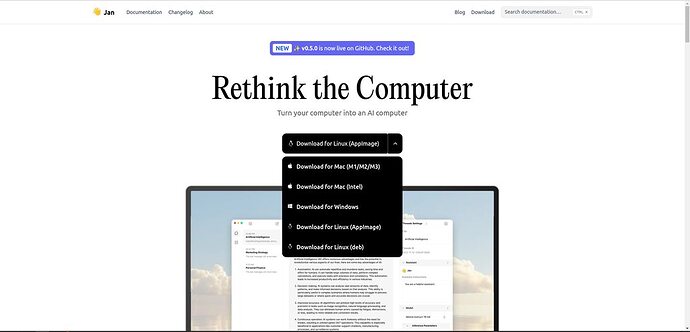

Jan

Jan, es un software muy fácil de utilizar, se descarga el .deb, se instala, seleccionas el modelo y a escribir, tan fácil como a golpe de click, aquí te dejo el enlace para que descargues Jan.ai

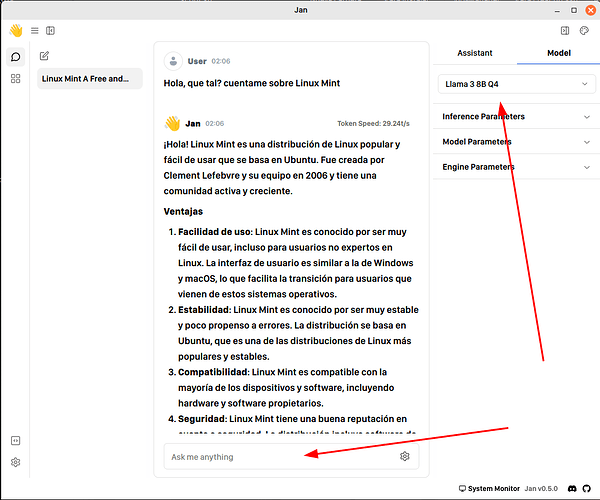

Estoy seguro de que no necesita casi explicación, pero te dejo esta imagen para que de manera gráfica se entienda lo sencillo que es, a la derecha selecciona tu modelo de lenguaje a utilizar y ya una vez se descargue puedes ponerte a escribir simplemente.

También puedes en la pestaña del asistente modificar su comportamiento, intentalo, pon “Eres un profesional en Linux” o bien “Eres mi novia, super cariñosa” ![]()

LM Studio

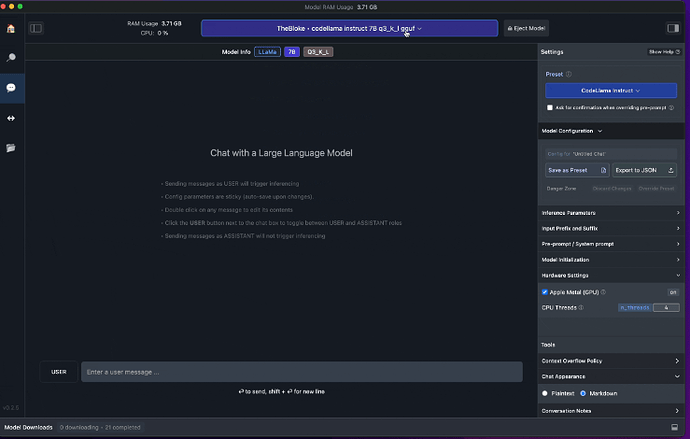

En primer lugar tenemos a LM Studio una gran herramienta para IA. En este caso LM Studio está disponible desde su página oficial de forma gratuita, también te dejamos su repositorio de Github por si te interesa.

Esta herramienta se encuentra disponible a día de hoy (15/03/2024) sólo en forma de AppImage, así que lo mejor es que tengas instalado AppImageLauncher para administrar de forma cómoda los AppImages.

![]()

La versión de AppImageLauncher disponible de momento es para Bionic pero funciona en versiones de Ubuntu Jammy 22.04 o Linux Mint 21.x.

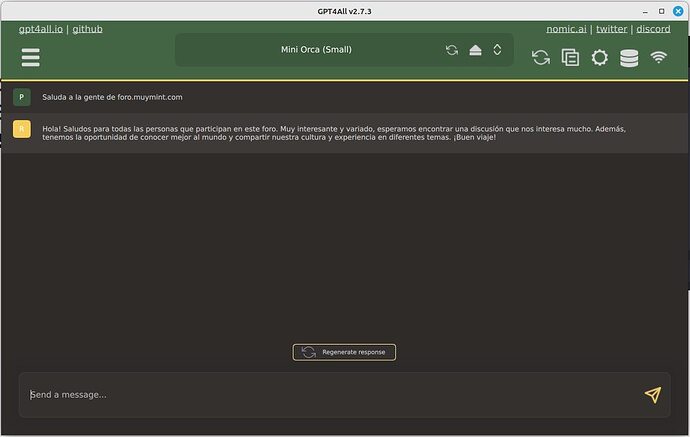

GPT4all

En segundo lugar tenemos a GPT4all, fantástica y sencilla herramienta de IA, una de las más sencillas de utilizar a mi parecer. Solo le das a descargar el modelo, lo cargas y a usar, no hay muchas más configuraciones avanzadas que hacer como usuario.

Por aquí te dejamos su Github por si quieres investigar un poco más allá.

Nota: Si conoces algún software más de IA hazmelo saber y lo añadiremos.

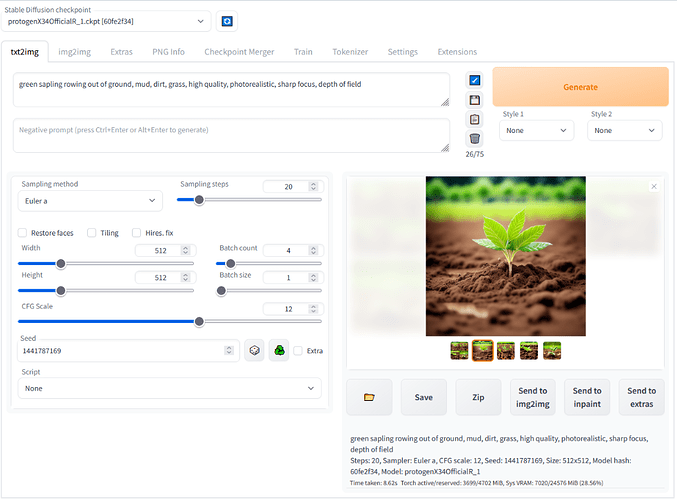

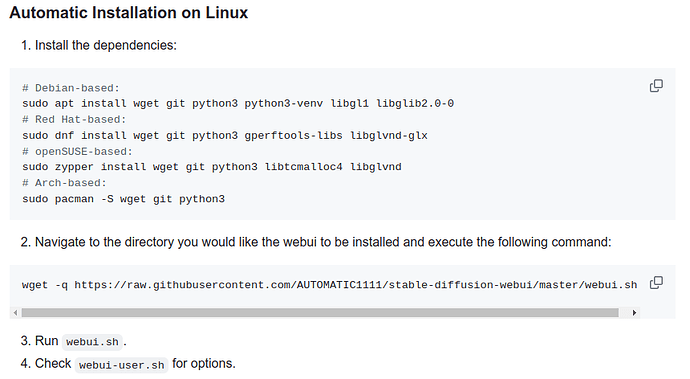

Stable Diffusion WebUI (AUTOMATIC1111)

De la mano de AUTOMATIC1111 tenemos Stable Diffusion WebUI, un generador de imágenes basado en texto, seleccionas el modelo, le dices lo que quieres y ¡voilá! tu imagen se genera. Es verdad que en este caso, si hay que saber un poco más, hay que configurar ciertos parámetros para obtener una buena imagen, no es full necesario, pero si que mejora mucho lo que puedes hacer con él. No es difícil de aprenderlo ¡Animate!

Las instrucciones para la instalación son super sencillas

-

sudo apt install wget git python3 python3-venv libgl1 libglib2.0-0(para todos los que tenemos Linux Mint o Ubuntu) -

Ve al directorio en el que quieres que se instale, abre una terminal dentro de ese directorio y pon

wget -q https://raw.githubusercontent.com/AUTOMATIC1111/stable-diffusion-webui/master/webui.sh

- Ahora solo ejecuta con

webui.sh

Opcional: Puedes crear un acceso directo del mismo y ponerle ponerle un icono de AUTOMATIC1111 bajado de internet.

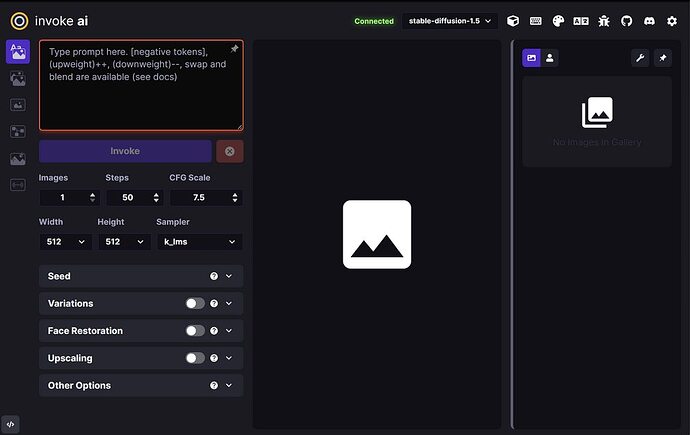

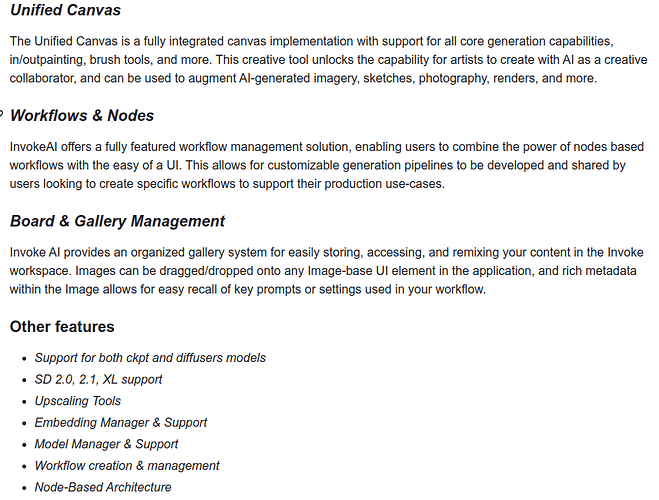

Invoke-ai

Invoke-ai es uno de mis sofware favoritos para crear imágenes con texto, tiene muchísimas utilidades interesantes dentro.

De aquí para abajo la instalación de software es de nivel intermedio

Ollama + Open-WebUI

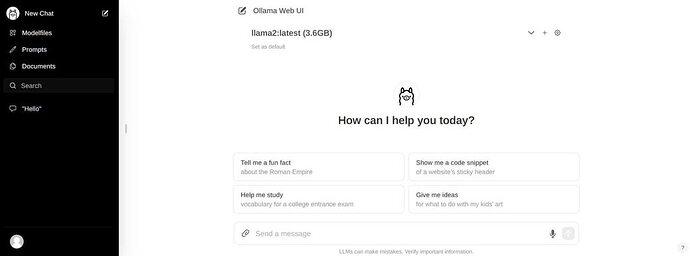

Ollama es un backend de IA el cual se encarga de la mayor parte de la tarea de ejecutar un modelo de IA en tu Linux, combinado con la interfaz web del proyecto Open-WebUI creamos una plataforma de IA que nada tiene que envidiar a las demás.

Mi recomendación es utilizar docker para montarlo (instala docker en Mint/Ubuntu fácil)

La instalación de Ollama en docker

Solo CPU

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

Si tenés Nvidia

1- Instalamos “Container ToolKit”

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \ && curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \ sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \ sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

2- Luego

sudo apt-get update

3- Ante ultimo paso

sudo apt-get install -y nvidia-container-toolkit

4- Ultimo paso

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

Instalamos y ejecutamos Open-WebUI

Solo CPU

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Si instalaste con Nvidia

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

Solo te queda abrir tu navegador y entrar en localhost:3000

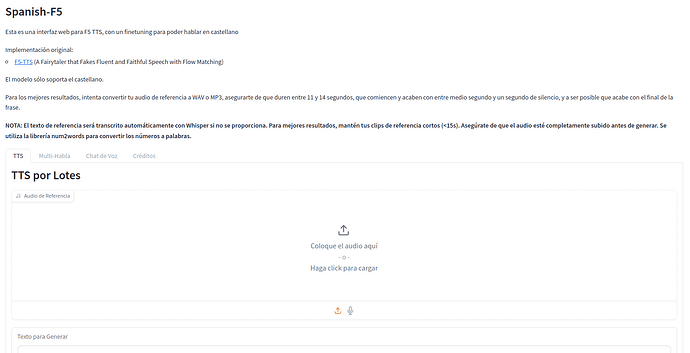

F5-TTS en español

Entrenado por Juan Pablo Gallegos, es un modelo de clonación de voz que puedes probar en HuggingFace o bien montar tu propio docker. Te dejo el link de GitHub y de HuggingFace para que puedas probarlo.

Juan Pablo Gallego en Twitter para seguir las novedades.